Die Toxizität von Multiplayer-Spielen könnte durch diese Funktion massiv reduziert werden.

Sonys neues Patent will den Voice-Chat im Spiel moderieren und Beschimpfungen unterbinden, indem es den Ton und die Lautstärke des Täters ändert. Das Patent besagt, dass der Spieler viele Aspekte kontrollieren und entscheiden kann, wer moderiert werden soll, um die Funktion flexibel zu gestalten. Es wird KI verwenden, um automatisch den Tonfall, die Emotionen und die Lautstärke der Nutzer zu erkennen, bevor es Maßnahmen ergreift.

Sony hat bereits mehrere Initiativen ins Leben gerufen, um das Spielen für die PlayStation-Community sicherer und unterhaltsamer zu machen. Die jüngste Initiative des Publishers spiegelt sich in dem neuen Patent wider, in dem es um eine interessante Funktion zur Sprachmoderation geht. In dem neu veröffentlichten juristischen Dokument spricht Sony von einem einzigartigen System, das umgeschaltet werden kann, um alle eingehenden emotionalen Ausbrüche und toxischen Äußerungen von Spielern auf verschiedene Weise zu blockieren.

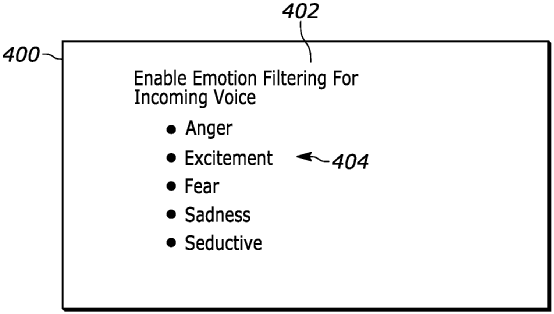

Das Patent mit dem Namen „DIGITAL AUDIO EMOTIONAL RESPONSE FILTER“ kann zwischen den Tönen, Wörtern und Frequenzen der Benutzer während des Voice-Chats unterscheiden. Sonys einzigartiges System kann laute Äußerungen oder emotionale Ausbrüche herausfiltern, indem es entweder die Lautstärke des Spielers verringert oder den Tonfall ändert. Außerdem kann der Ton des bösen Schauspielers in eine KI-Stimme mit einem weicheren Ton geändert werden, um ein angenehmeres Spielerlebnis zu ermöglichen.

„Der eingehende Audiopegel kann normalisiert werden, wenn ein Benutzer zu schreien beginnt, oder die Tonalität kann entfernt werden, wenn wütende/aggressive Töne verwendet werden, um eine roboterhafte oder tonlose Stimme zu erzeugen“, heißt es im Patent.

Sony argumentiert, dass Spieler sich vor wütenden Ausbrüchen oder hitzigen Gesprächen während des Spiels schützen wollen. Eine gängige Lösung für dieses Dilemma wäre es, die giftigen Nutzer zu blockieren, aber das könnte auch dazu führen, dass man sich nicht mehr an Diskussionen beteiligen kann. Das System will den übermäßigen Tonfall oder das Geschrei normalisieren, ohne die Stimme vollständig zu blockieren. Dies kann dazu beitragen, dass sich die Spieler trotz des daraus resultierenden gefilterten Chaos miteinander beschäftigen.

„In sozialen Netzwerken kann es sein, dass ein Hauptnutzer keine übermäßigen Emotionen in der Sprachwiedergabe eines anderen Nutzers im Netzwerk wahrnehmen möchte, oder dass er bestimmte Arten von Emotionen nicht wahrnehmen möchte, aber dennoch den Inhalt dessen, was ein emotionaler Nutzer sagt, wahrnehmen möchte.“

In dem Patent wird auch erwähnt, dass die Spieler die Möglichkeit haben, zu wählen, wessen Stimme vom System gefiltert wird. So kann beispielsweise die Stimme eines Nutzers, der laut oder wütend ist, verändert werden, während der andere, der emotional spricht, seine natürliche Stimme beibehalten kann. Diese Funktion, bei der KI und maschinelle Lernmodelle zum Einsatz kommen, wird zusätzliche Flexibilität bieten, die sie zu einer praktikablen Moderationsoption im modernen Spiele-Ökosystem von Sony machen kann.

Der Konzern hat bereits ein ähnliches Patent veröffentlicht, mit dem unmoralisches Verhalten aus Sprachchats in Spielen entfernt werden sollte. In diesem Dokument hieß es, dass die Täter mit angemessenen Strafen für die Teilnahme an derartigen Handlungen bestraft werden sollen, da man die Spieler vor möglichen Auslösern für psychische Probleme schützen möchte.